Что такое Crawlability: 11 способов исправить ошибки Crawl

Что такое Crawlability?

Здравствуйте, мои дорогие SEO-друзья и энтузиасты! Сегодня я хотел бы поговорить о crawlability, наиболее распространенных проблемах crawlability и способах их решения. Этот жизненно важный фактор может навредить вашему рейтингу, трафику и видимости сайта в результатах поиска. Прежде чем перейти к рассмотрению ошибок ползания, давайте выясним, что такое ползаемость и как она влияет на SEO.

Простыми словами, crawlability — это способность ботов поисковых систем обнаруживать и правильно просматривать страницы вашего сайта. Это важная часть технического SEO. Если Googlebot не может найти ваши веб-страницы, они не будут показываться в поисковых результатах.

Важно отличать crawlability от indexability: первое — это возможность сканирования, второе — возможность включения страницы в индекс поисковой системы.

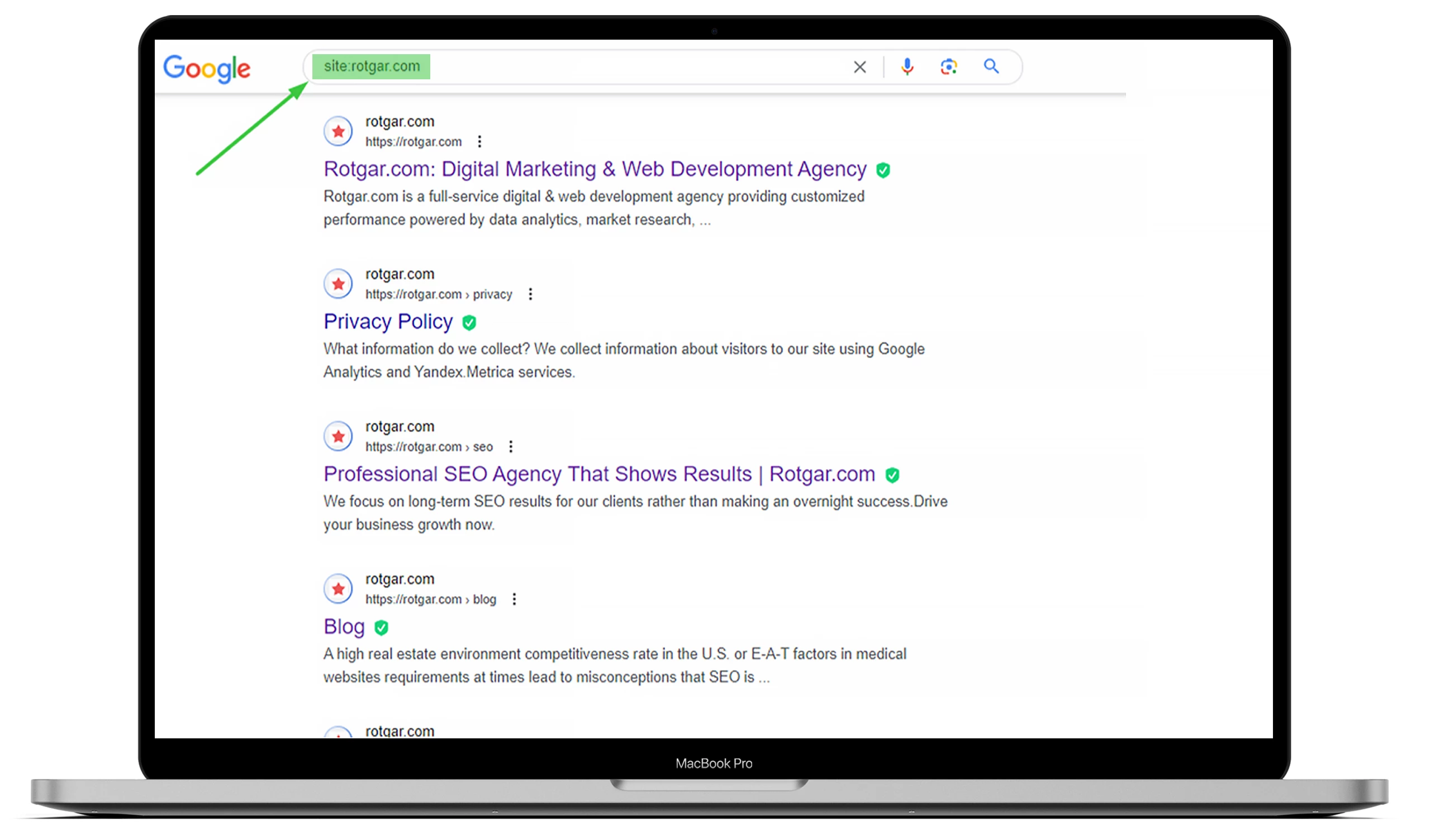

Чтобы узнать, сколько страниц проиндексировано, используйте команду site:ваш_домен в Google.

Поисковые боты работают непрерывно, сканируя и обновляя страницы. Если у них возникают трудности с обходом вашего сайта, это может повлиять на SEO, рейтинг и трафик.

Как ошибки Crawlability влияют на SEO

Если боты не могут просканировать ваши страницы, они не будут знать, что вы предлагаете. Это приведет к тому, что страницы не попадут в индекс и не появятся в результатах поиска, а значит — вы потеряете потенциальный трафик и клиентов.

Вывод: чем удобнее сайт для обхода, тем выше шанс, что его страницы будут проиндексированы и получат хороший рейтинг.

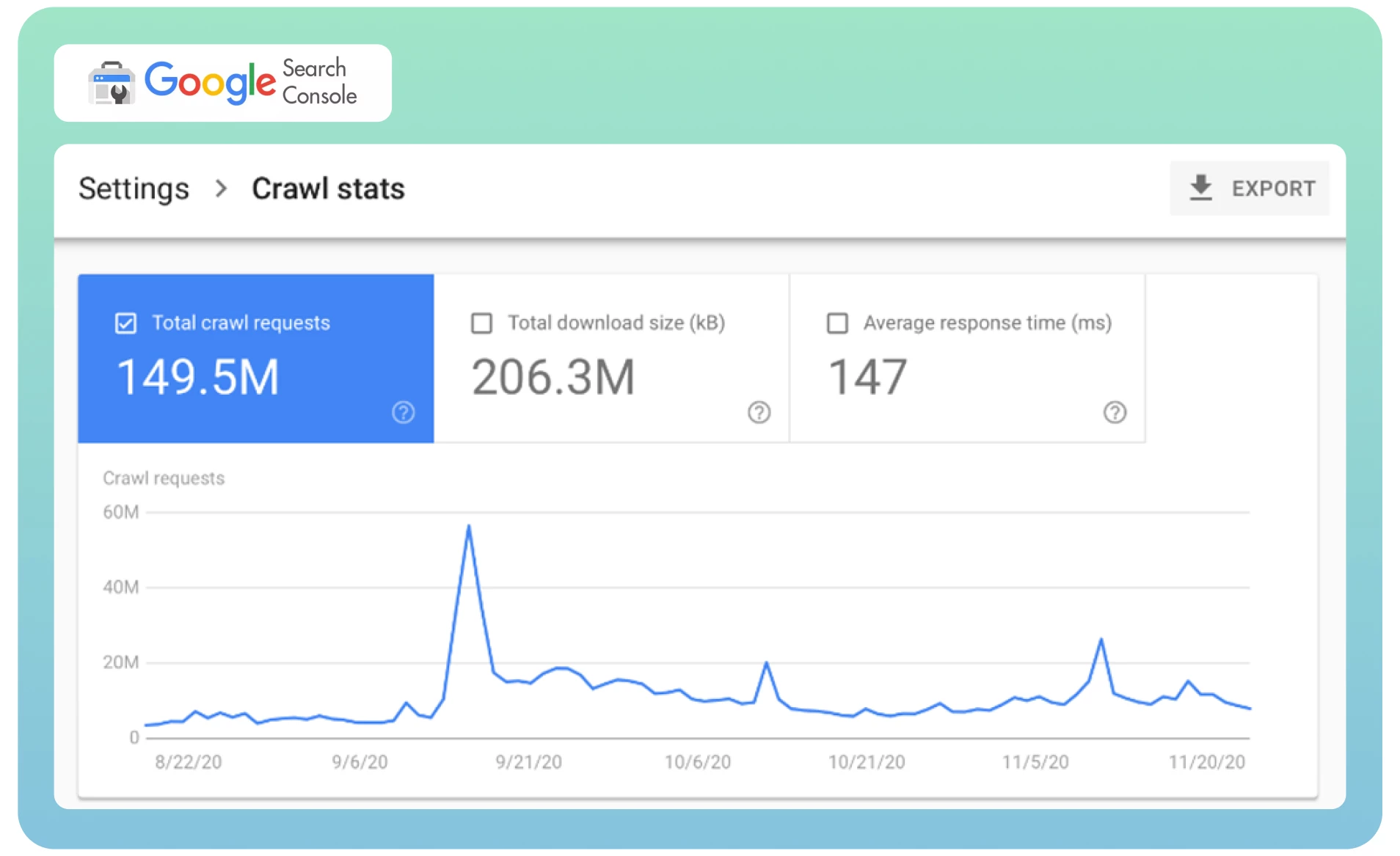

Как найти ошибки Crawlability в Google Search Console

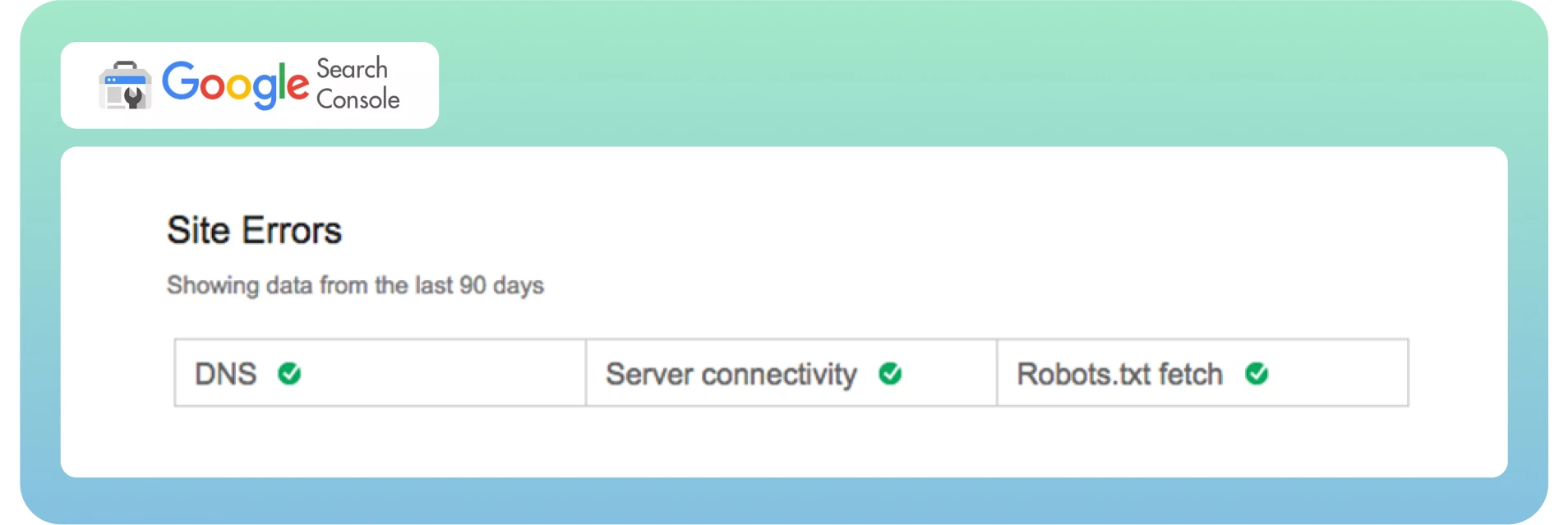

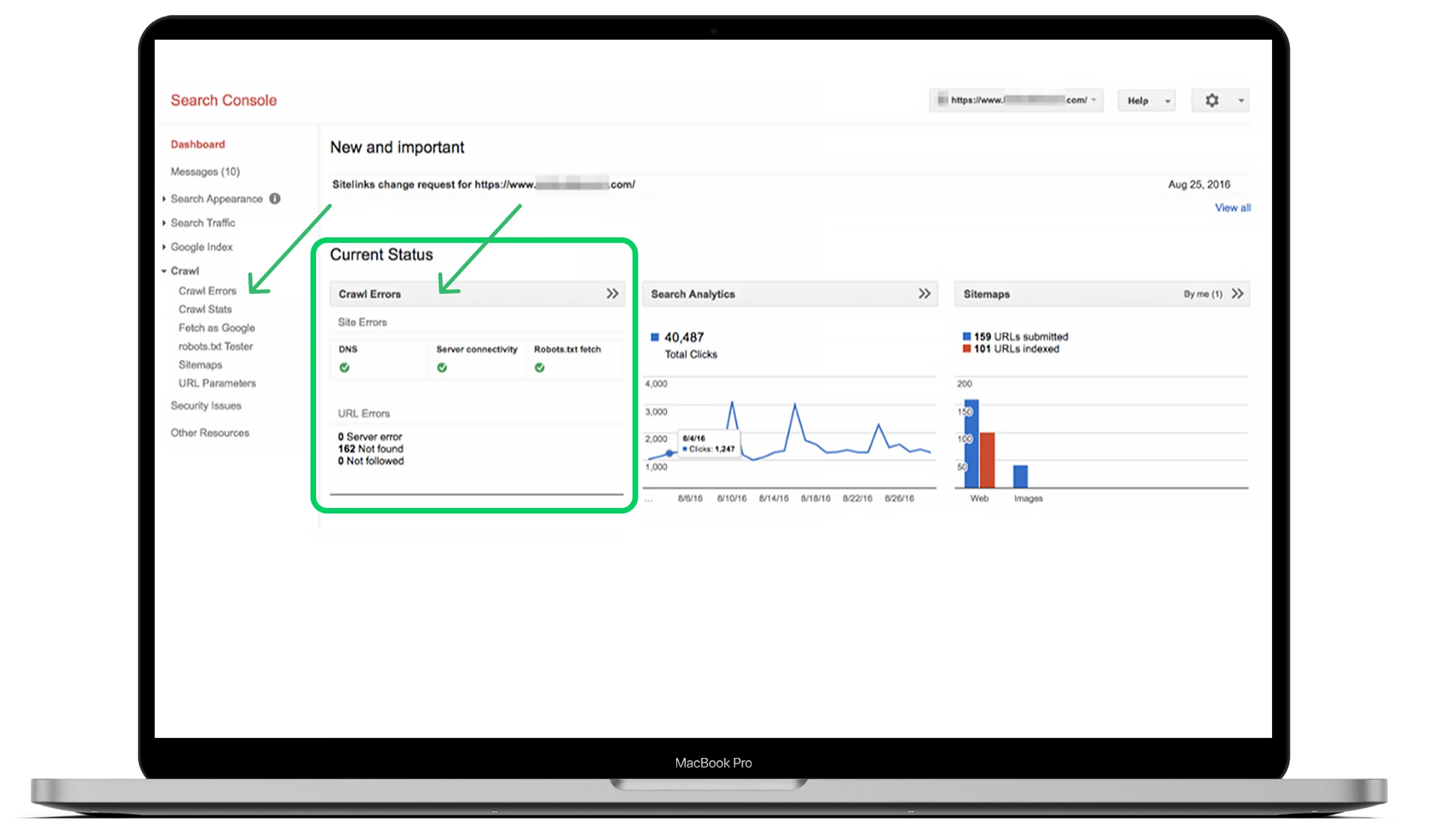

Google Search Console показывает ошибки ползания в двух разделах:

- Ошибки сайта — влияют на доступность всего сайта, требуют срочного исправления.

- Ошибки URL — касаются конкретных страниц, но также важны для SEO.

Рекомендуется регулярно проверять этот раздел и устранять все ошибки. Для этого откройте GSC, перейдите в раздел «Crawl» и нажмите на «Crawl Errors».

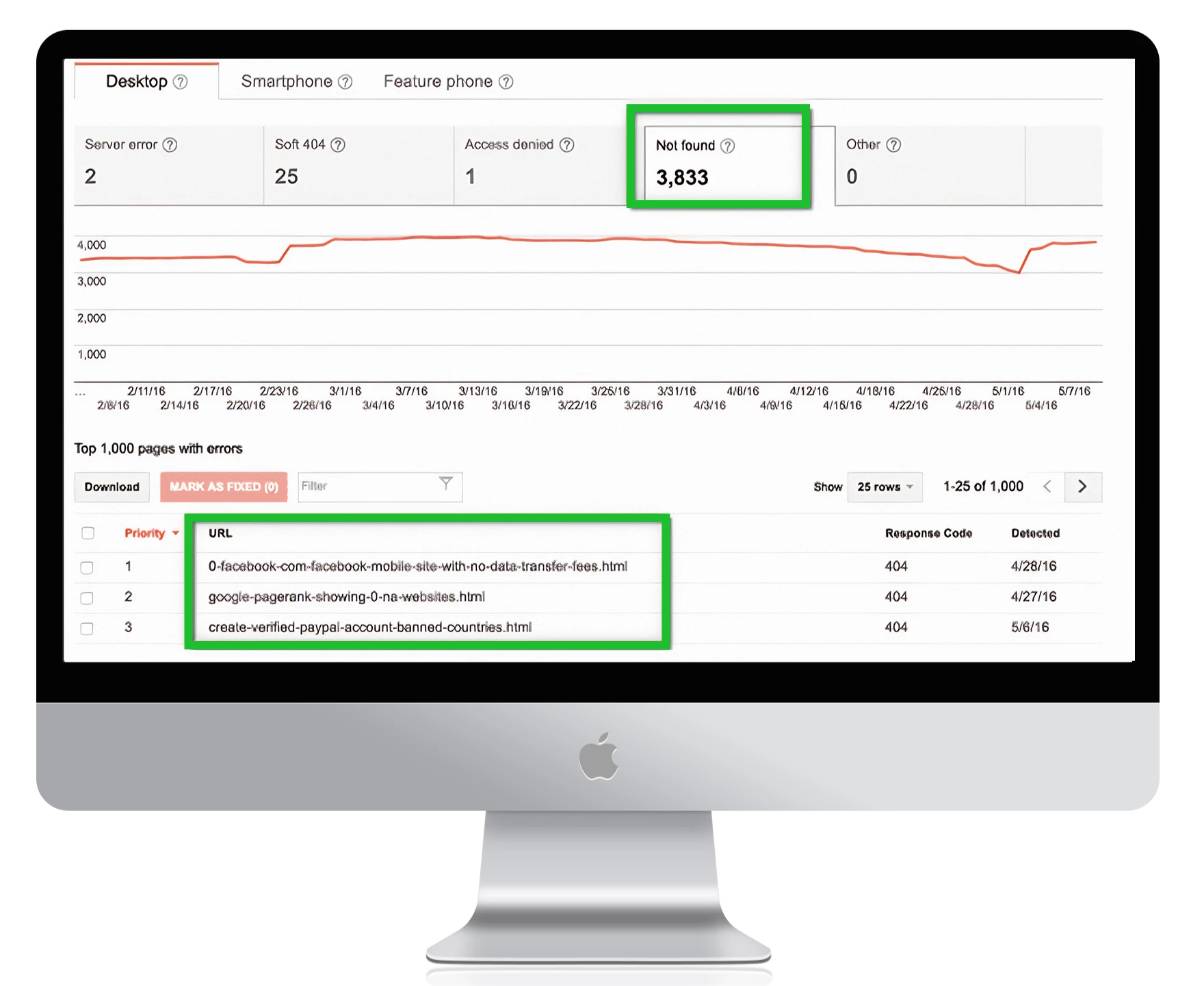

1. Ошибки 404

Ошибка 404 — это одна из самых распространённых и одновременно противоречивых проблем

crawlability. Теоретически, она возникает, когда Googlebot пытается получить доступ к

странице, которая не существует. На практике таких страниц может быть много, и не все

из них действительно вредят SEO.

«404 ошибки не сильно влияют на производительность и рейтинг вашего сайта в Google,

поэтому вы можете смело их игнорировать» — Google

Однако если страница с ошибкой 404 получает органический трафик, имеет внешние ссылки или

представляет собой важный элемент сайта, её необходимо восстановить или корректно

перенаправить.

Решения

- Проверьте, действительно ли страница удалена или просто временно недоступна.

- Убедитесь, что URL корректный и не содержит ошибок, включая протокол (http/https) и поддомен (www/без www).

- Если страница больше неактуальна — настройте 301 redirect на релевантную страницу.

- Если страницу можно восстановить — обновите контент и верните её в публикацию.

Как найти ошибки 404 в Google Search Console

Перейдите в Google Search Console → Отчёт об индексировании. Выберите вкладку

«Страницы» и отфильтруйте по статусу «Не найдено (404)». Вы увидите список URL-адресов,

с которыми возникли проблемы.

1. Soft 404 ошибки

Если у вас есть пользовательская страница 404, которая не возвращает статус 404, Google может отметить ее как soft 404. Это означает, что страница существует технически (возвращает статус 200), но содержит мало полезного контента, что снижает эффективность сканирования сайта.

Ошибки Soft 404 могут сбить с толку владельцев сайтов, поскольку они выглядят как странный гибрид 404 и стандартной веб-страницы.

Убедитесь, что важные страницы сайта не ошибочно помечены как «мягкие 404».

2. Неполноценные ссылки

Поисковые системы могут не просматривать ссылки на страницах с тегом <meta name="robots" content="nofollow">, что снижает доступность страниц для индексации.

Часто такие ошибки связаны с:

- JavaScript и Flash;

- редиректами и куками;

- фреймами и старыми URL.

Решение

- Используйте «Fetch as Google» для анализа.

- Проверьте редиректы и сократите их цепочки.

- Добавляйте только финальные URL в карту сайта.

- Улучшайте внутреннюю архитектуру сайта.

- Удалите ненужные nofollow-теги.

3. Заблокированные страницы

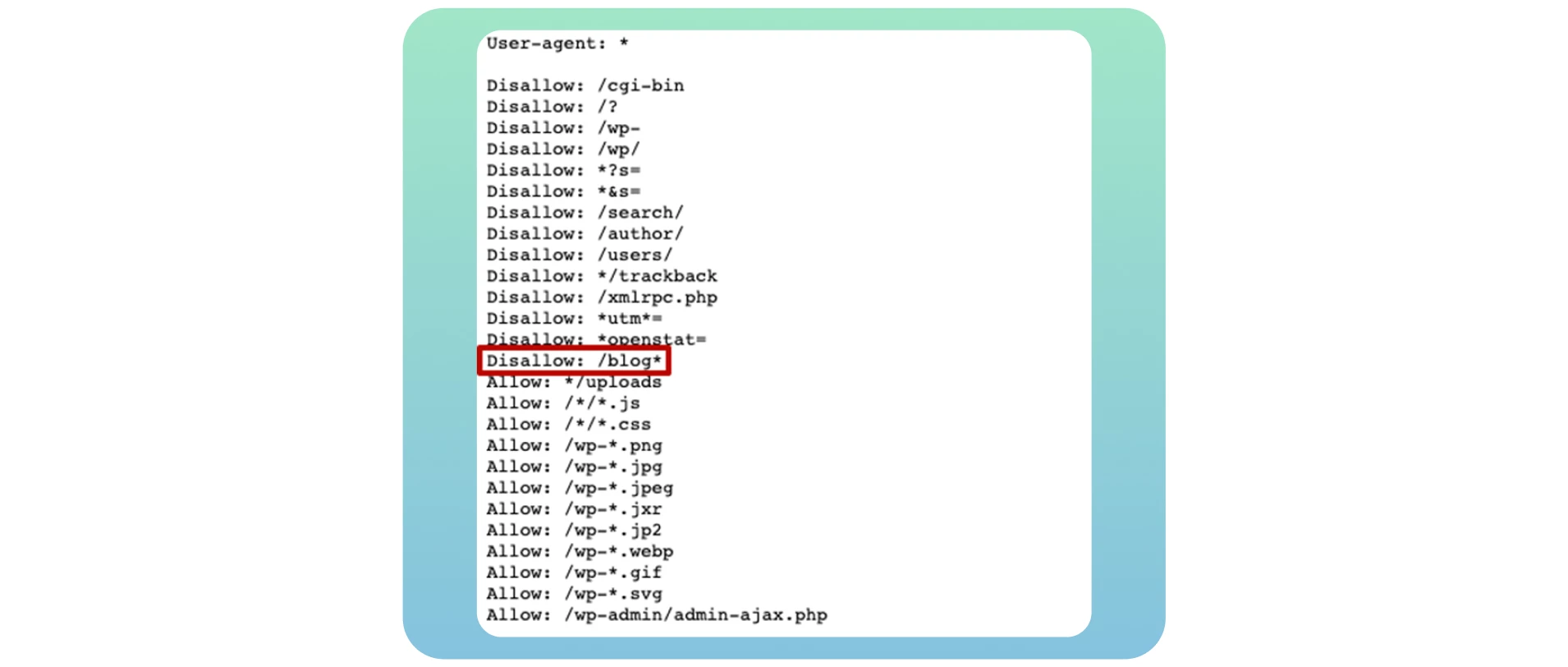

Файл robots.txt указывает поисковым системам, что можно или нельзя сканировать. Пример блокировки всего сайта:

User-agent: *

Disallow: /Чтобы открыть сайт для индексации:

User-agent: *

Allow: /Если вы хотите закрыть только блог:

Disallow: /blog*

Решение

- Разрешите индексацию нужных страниц через robots.txt.

- Проверьте файл с помощью инструмента тестирования robots.txt.

- Используйте Screaming Frog или Semrush для аудита.

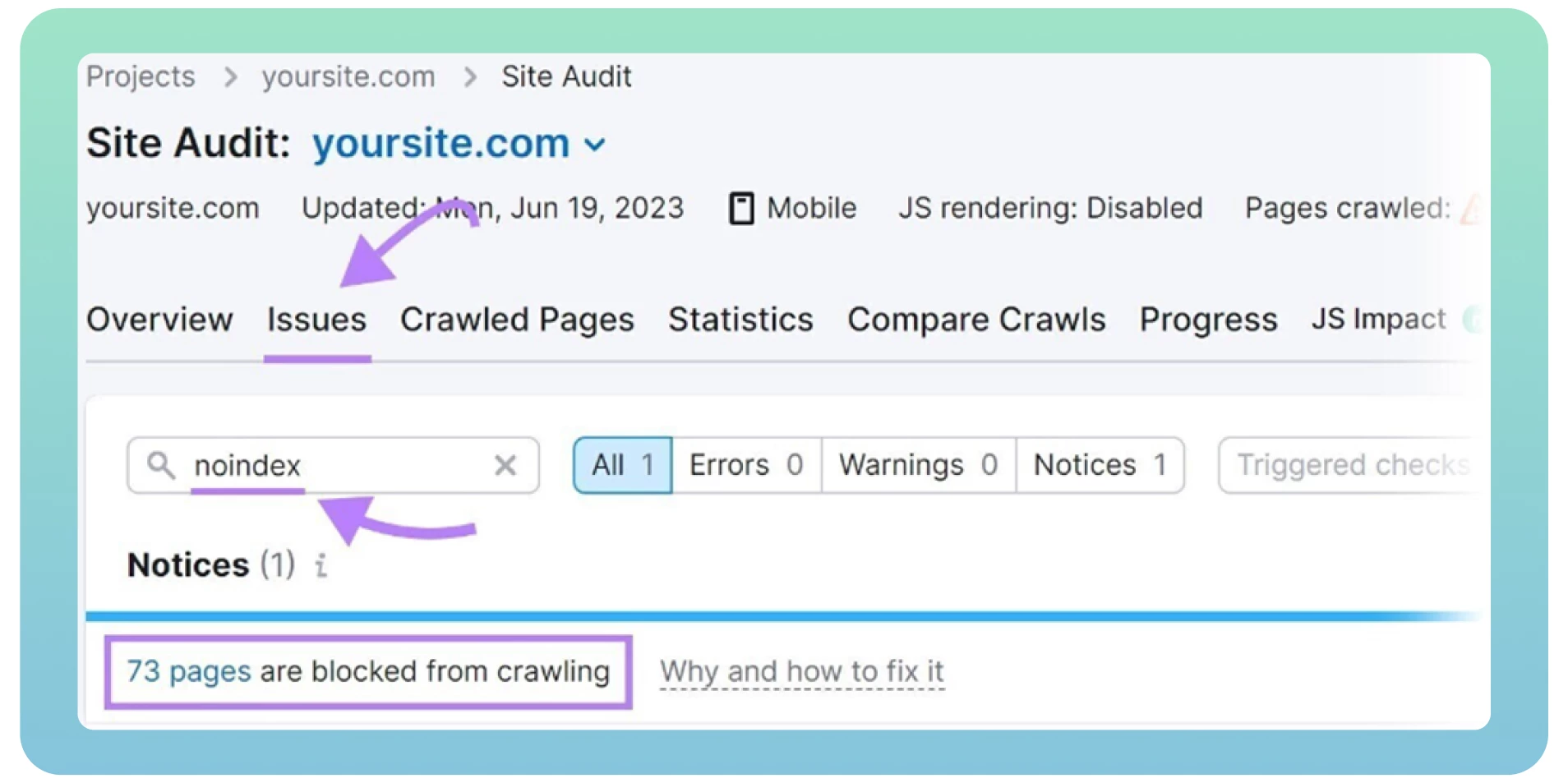

4. Теги «noindex»

Тег <meta name="robots" content="noindex"> запрещает индексацию страницы.

Этот тег часто забывают удалить после релиза сайта, особенно со страниц благодарности, логина или админ-панели.

Google воспринимает «noindex» как «nofollow» и прекращает следовать по ссылкам на таких страницах.

Решение

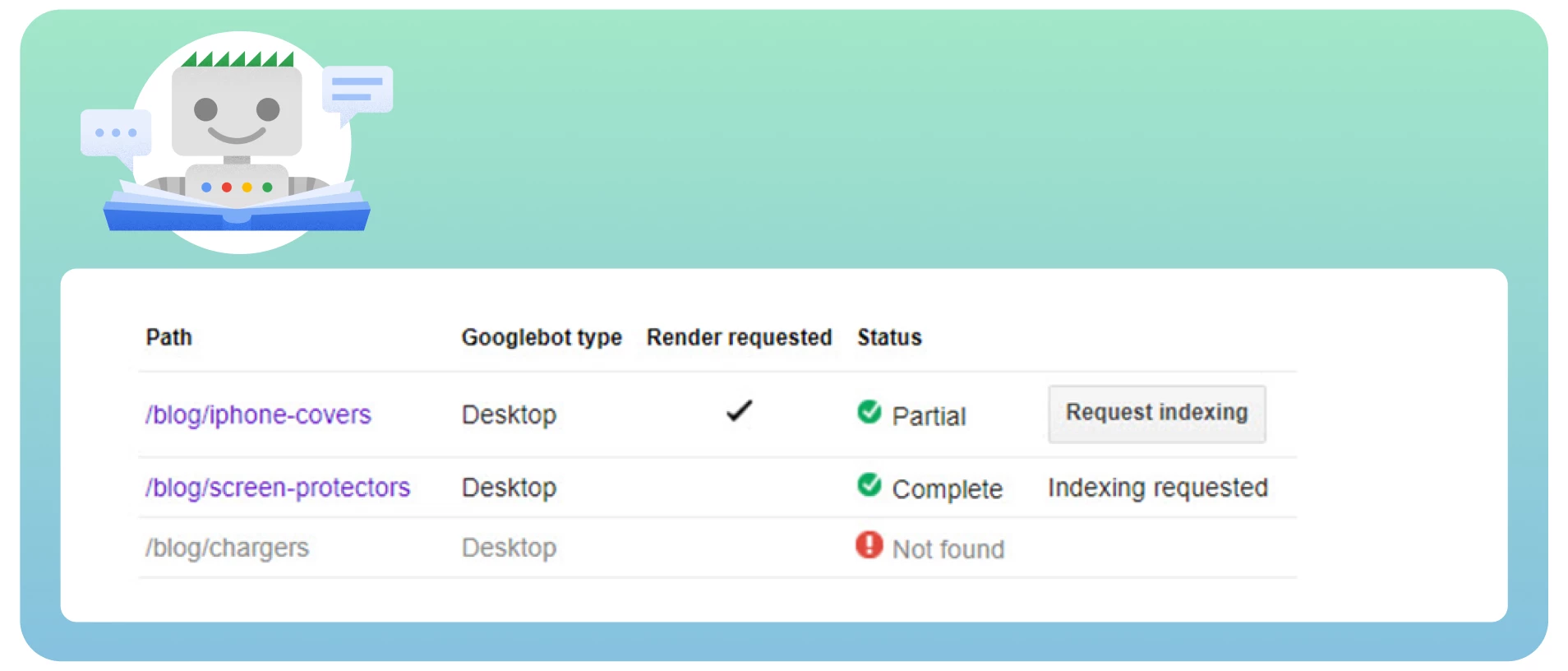

- Проанализируйте частоту посещения страниц ботом через Google Search Console.

- Запросите переиндексацию через инструмент Removals.

- Используйте Semrush или Screaming Frog для выявления таких страниц.

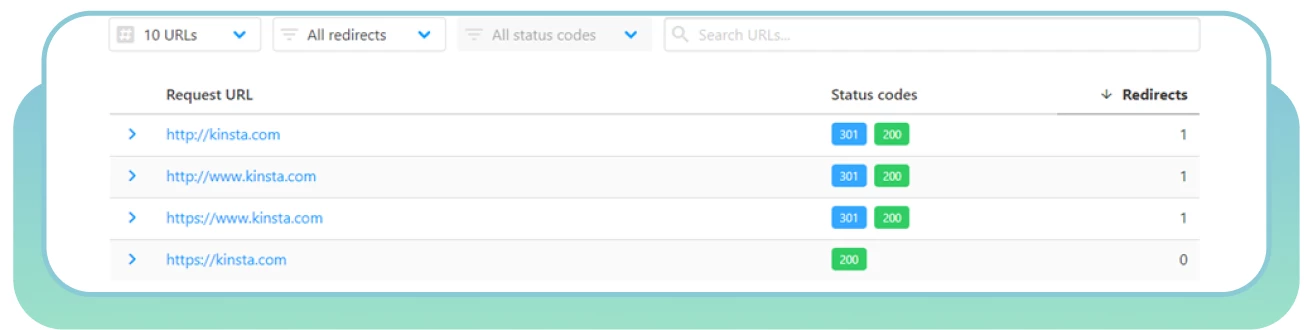

5. Дубликаты страниц

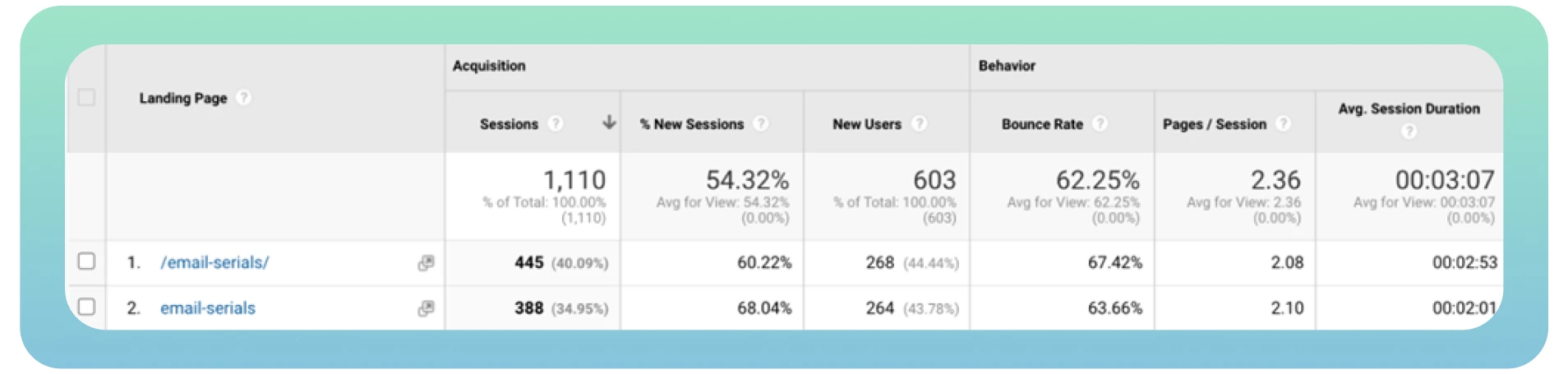

Разные веб-страницы с одинаковым содержимым могут загружаться с разных URL-адресов. Например, www и не www версии сайта. Это не влияет на пользователей, но влияет на поисковые системы.

Хуже всего то, что поисковые системы не могут определить, какую страницу считать приоритетной из-за дублирующегося контента.

Это усложняет анализ трафика и рейтинга в Google Analytics.

Решение

- Используйте канонические теги:

<link rel="canonical" href="https://example.com/page/" /> - Проверьте предупреждения в Google Search Console.

- Не используйте одновременно теги canonical и noindex.

- Канонизируйте страницы «Просмотреть все».

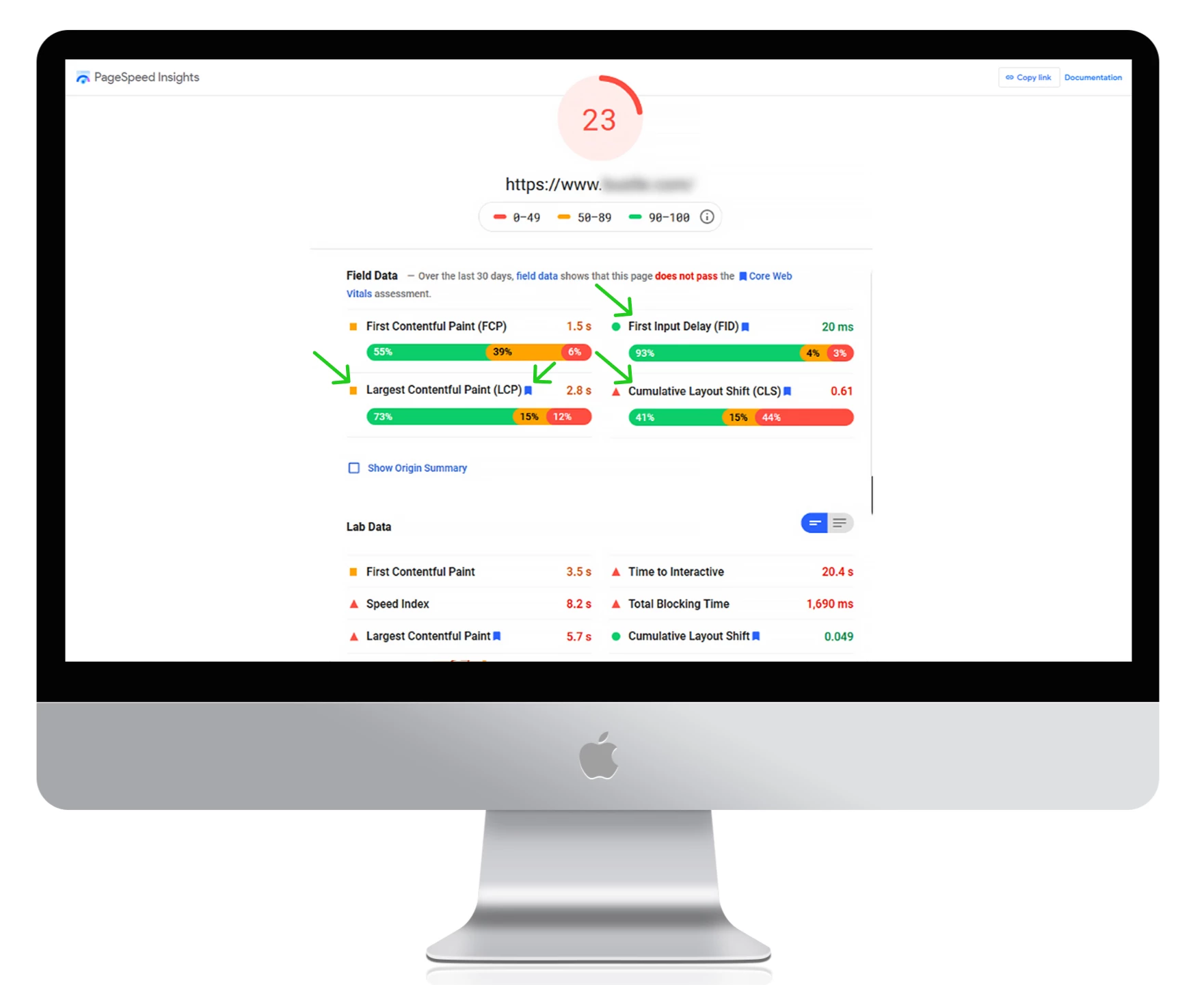

6. Низкая скорость загрузки

Скорость загрузки страниц — один из наиболее важных факторов, влияющих на посещаемость вашего сайта. Медленные страницы могут ухудшить опыт пользователей и сократить количество страниц, которые боты могут просканировать за один сеанс.

Чем быстрее загружаются страницы, тем быстрее бот Google сможет просмотреть сайт и повысить его позиции в выдаче.

Решение

- Используйте Google PageSpeed Insights для оценки и оптимизации скорости загрузки.

- Внедрите CDN для уменьшения задержек и распределения нагрузки.

- Выбирайте быстрого хостинг-провайдера.

- Сжимайте изображения и видеофайлы.

- Удаляйте ненужные плагины и минимизируйте CSS/JavaScript.

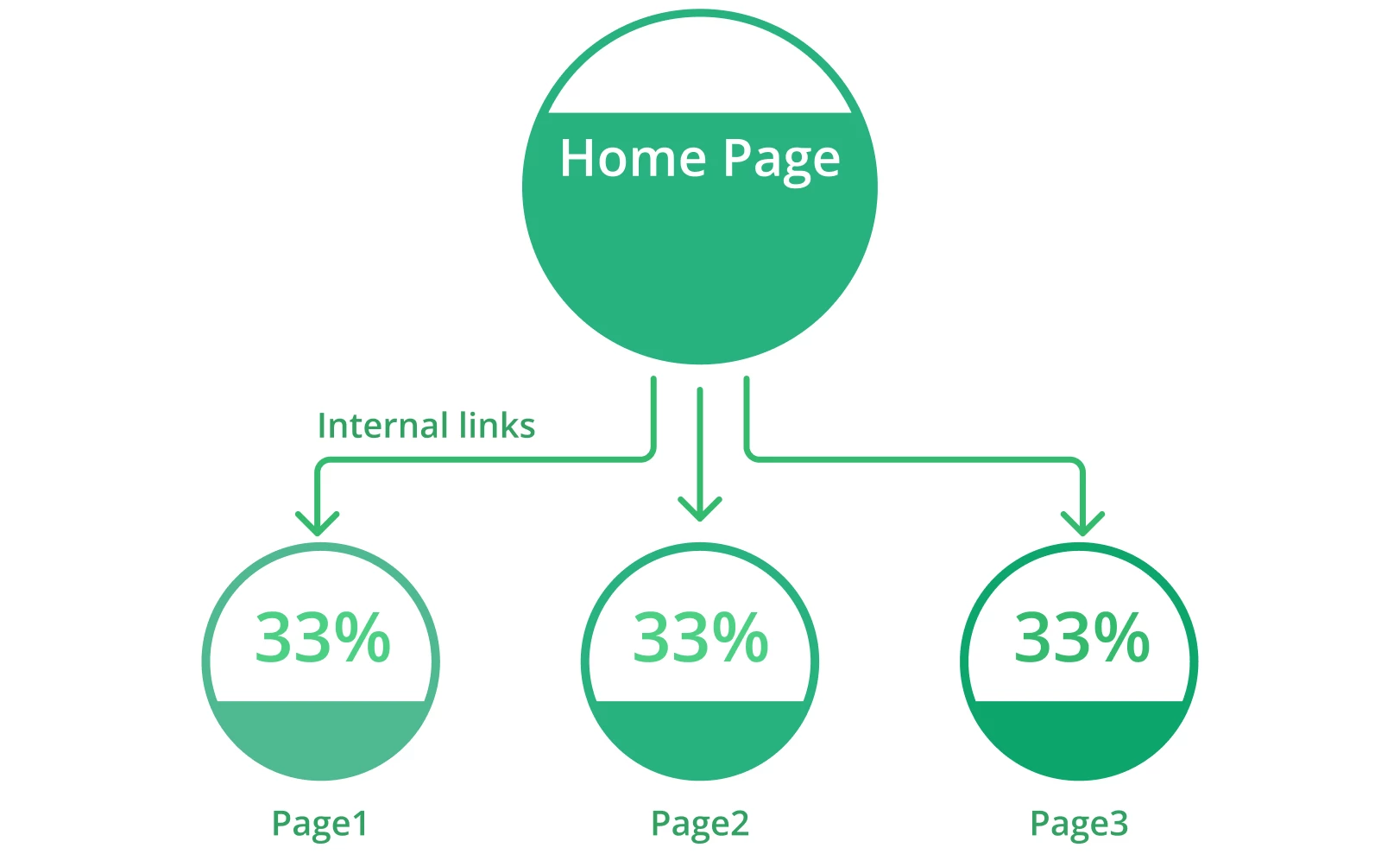

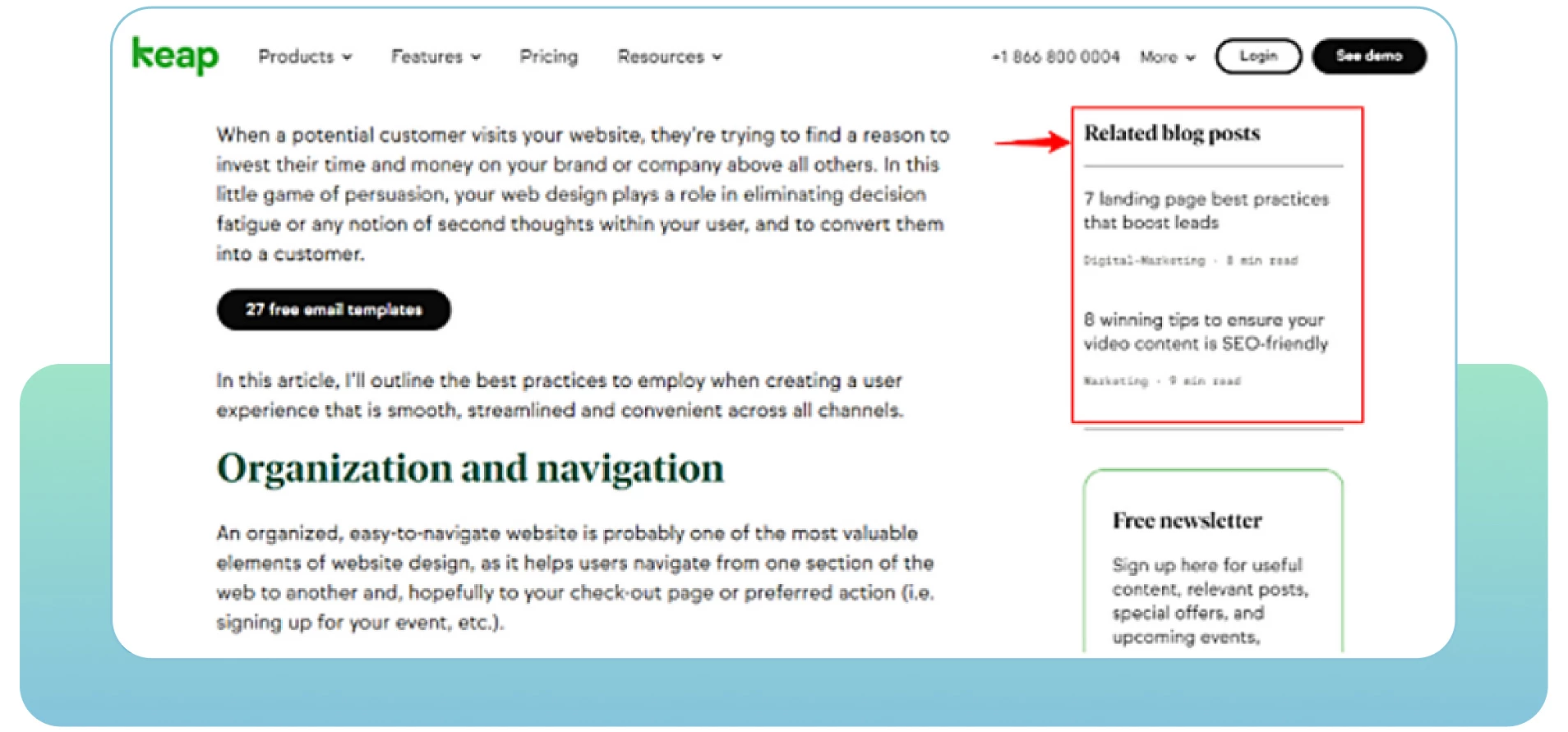

7. Отсутствие внутренних ссылок

Страницы без внутренних ссылок могут быть изолированы и не просканированы поисковыми ботами. Внутренние ссылки помогают навигации пользователей и указывают поисковым системам на структуру сайта.

Чем больше релевантных внутренних ссылок, тем лучше сканируемость и индексируемость сайта.

Решение

- Проведите SEO-аудит для выявления страниц без внутренних ссылок.

- Используйте аналитику, чтобы понять поведение пользователей и улучшить перелинковку.

- Улучшайте страницы с высоким показателем отказов, добавляя к ним внутренние ссылки и полезный контент.

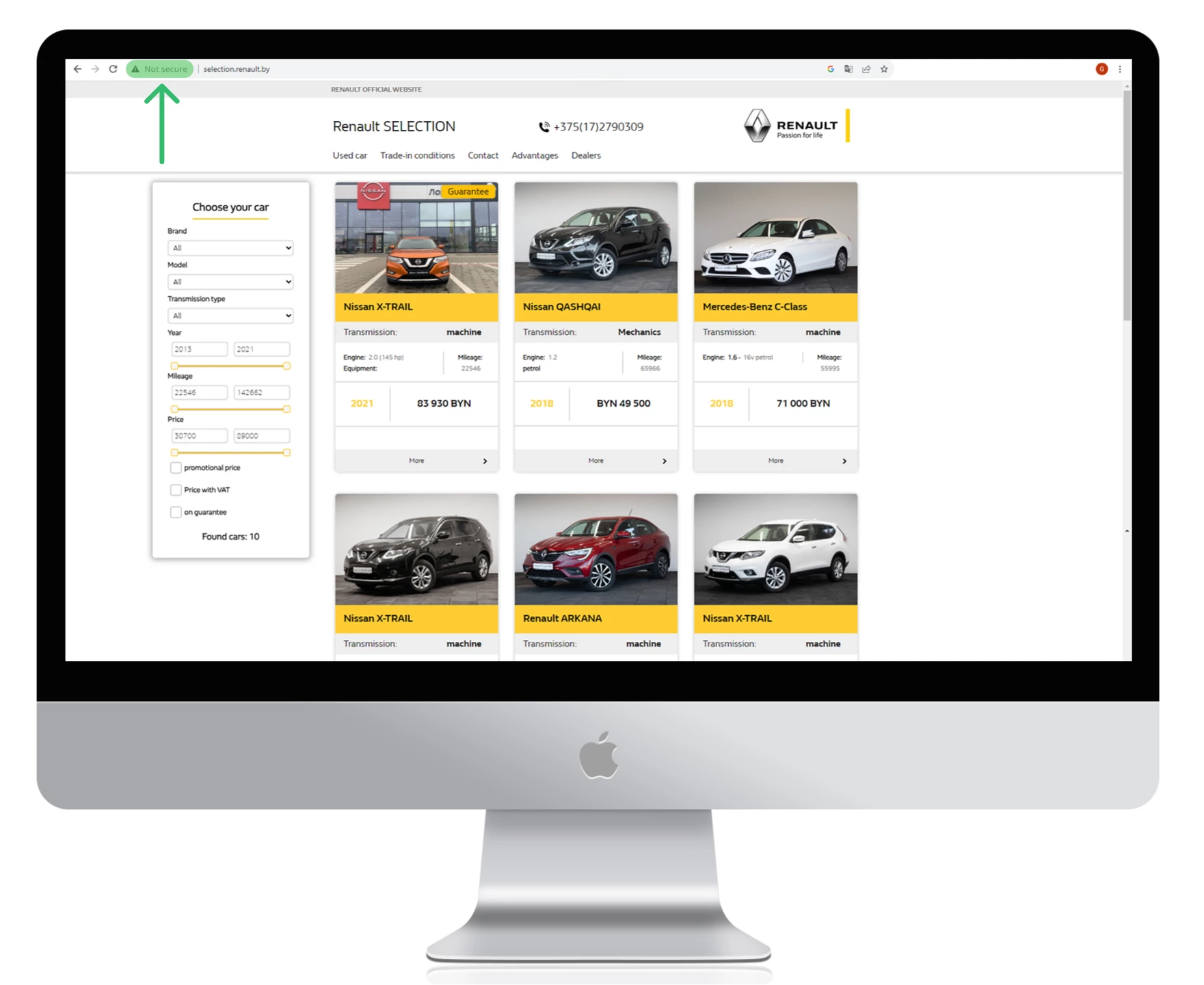

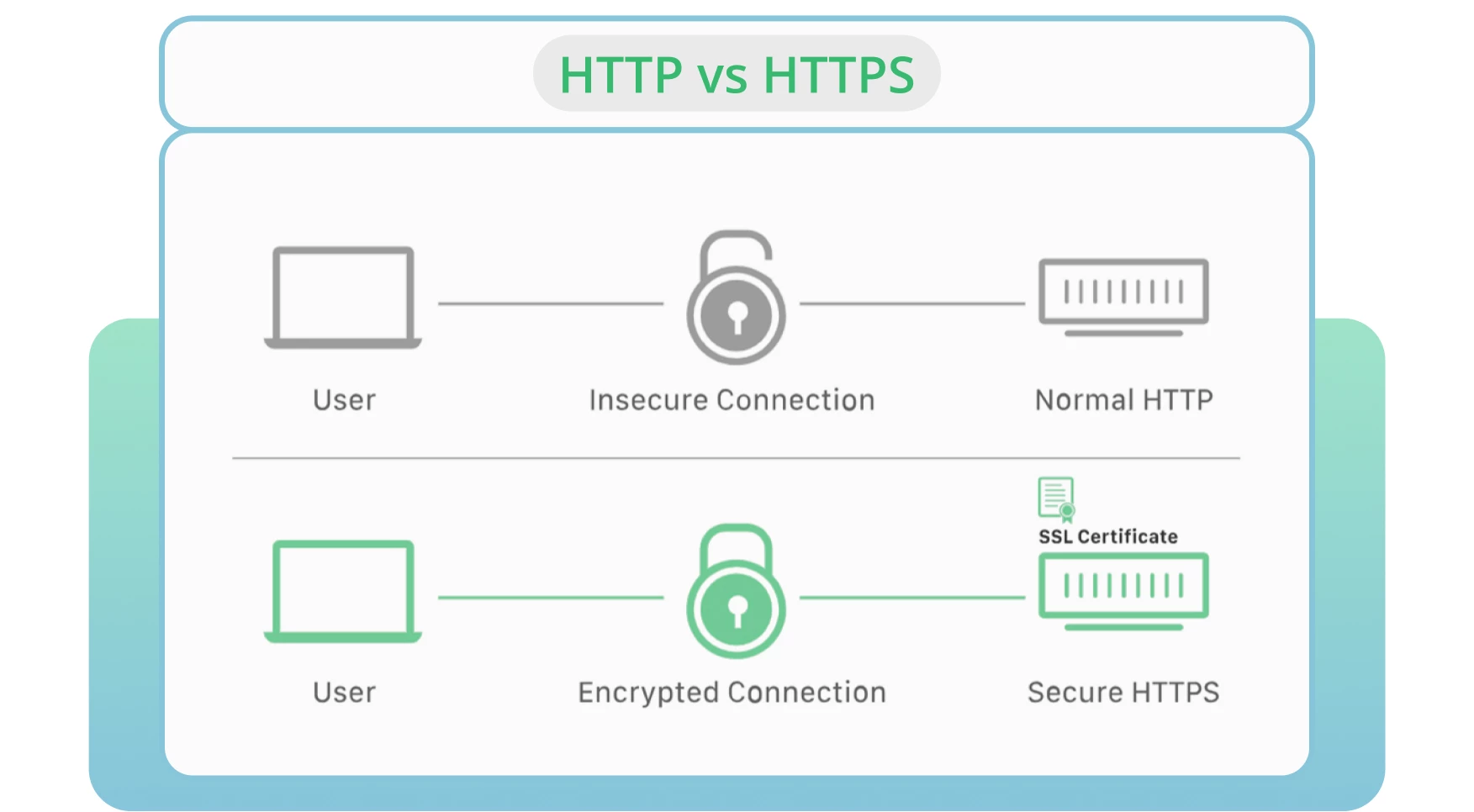

8. Использование HTTP вместо HTTPS

HTTP — стандартный протокол передачи данных, но HTTPS обеспечивает защищённое соединение. Браузеры и поисковые системы предпочитают HTTPS-страницы, так как они безопаснее.

Использование HTTPS помогает улучшить позиции сайта и обеспечить безопасность пользователей.

Решение

- Получите SSL-сертификат и переведите сайт на HTTPS.

- Следите за сроком действия сертификата и обновляйте его вовремя.

- Используйте современные протоколы безопасности.

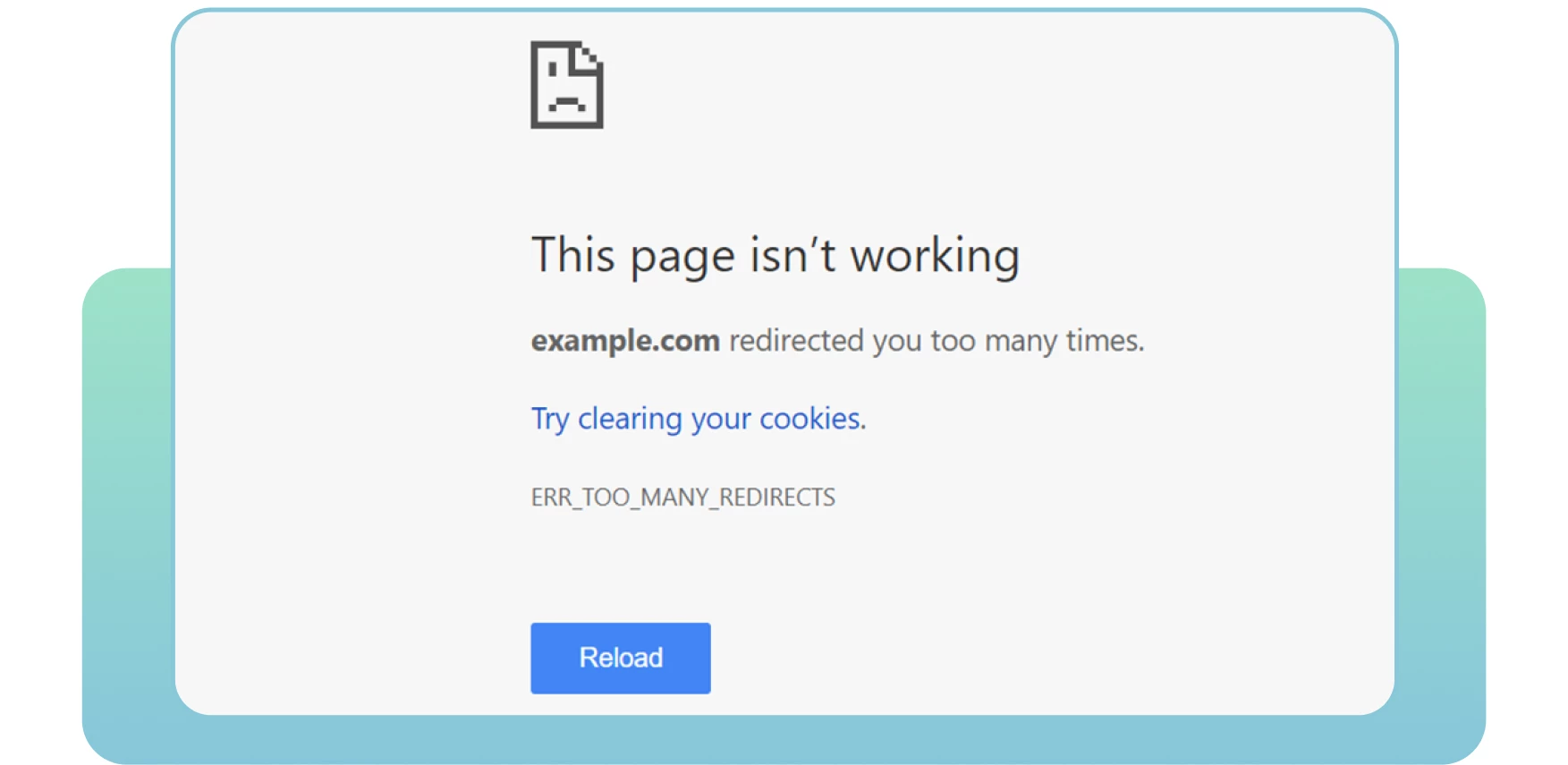

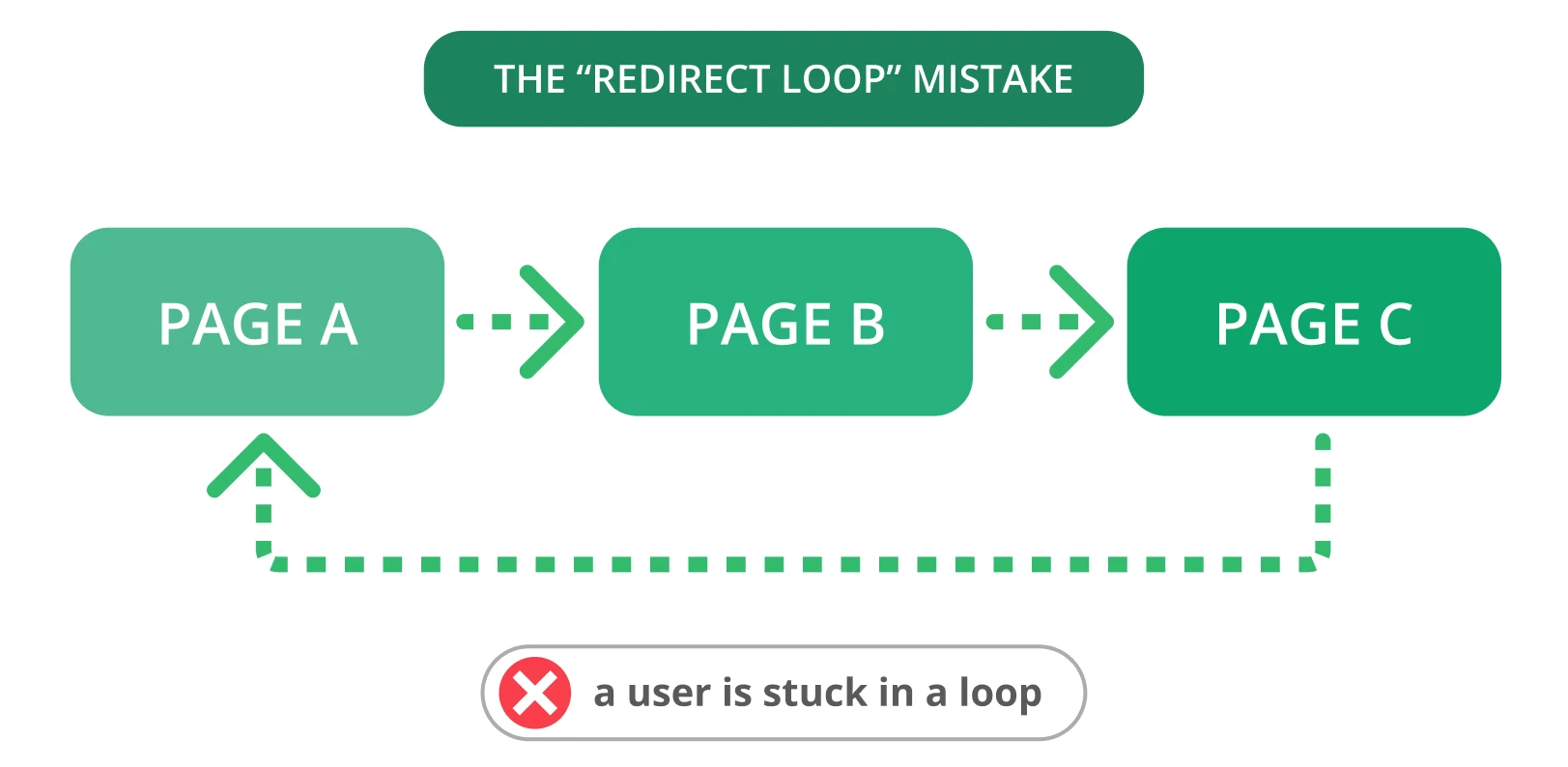

9. Петли перенаправления

Перенаправления нужны для правильной маршрутизации, но ошибки в их настройке могут вызвать петли. Это мешает индексации и ухудшает пользовательский опыт.

Петля редиректа — это бесконечный цикл между URL-адресами, вызывающий сбои у пользователей и поисковых ботов.

Решение

- Проверьте все цепочки редиректов на сайте.

- Избегайте множественных переходов между страницами.

- Настраивайте редиректы вручную, где это необходимо, и проверяйте их работоспособность с помощью SEO-инструментов.

Дополнительные рекомендации по устранению петель перенаправления

- Используйте HTTP Status Checker для выявления цепочек и кодов статуса HTTP.

- Выберите одну целевую страницу и перенаправьте на неё другие.

- Удалите перенаправления, вызывающие зацикливание.

- Помечайте страницы с кодом 403 как

nofollow, если они доступны только авторизованным пользователям. - Используйте временные редиректы, чтобы сообщить ботам о возвращении на страницу, и постоянные, если страница окончательно перемещена.

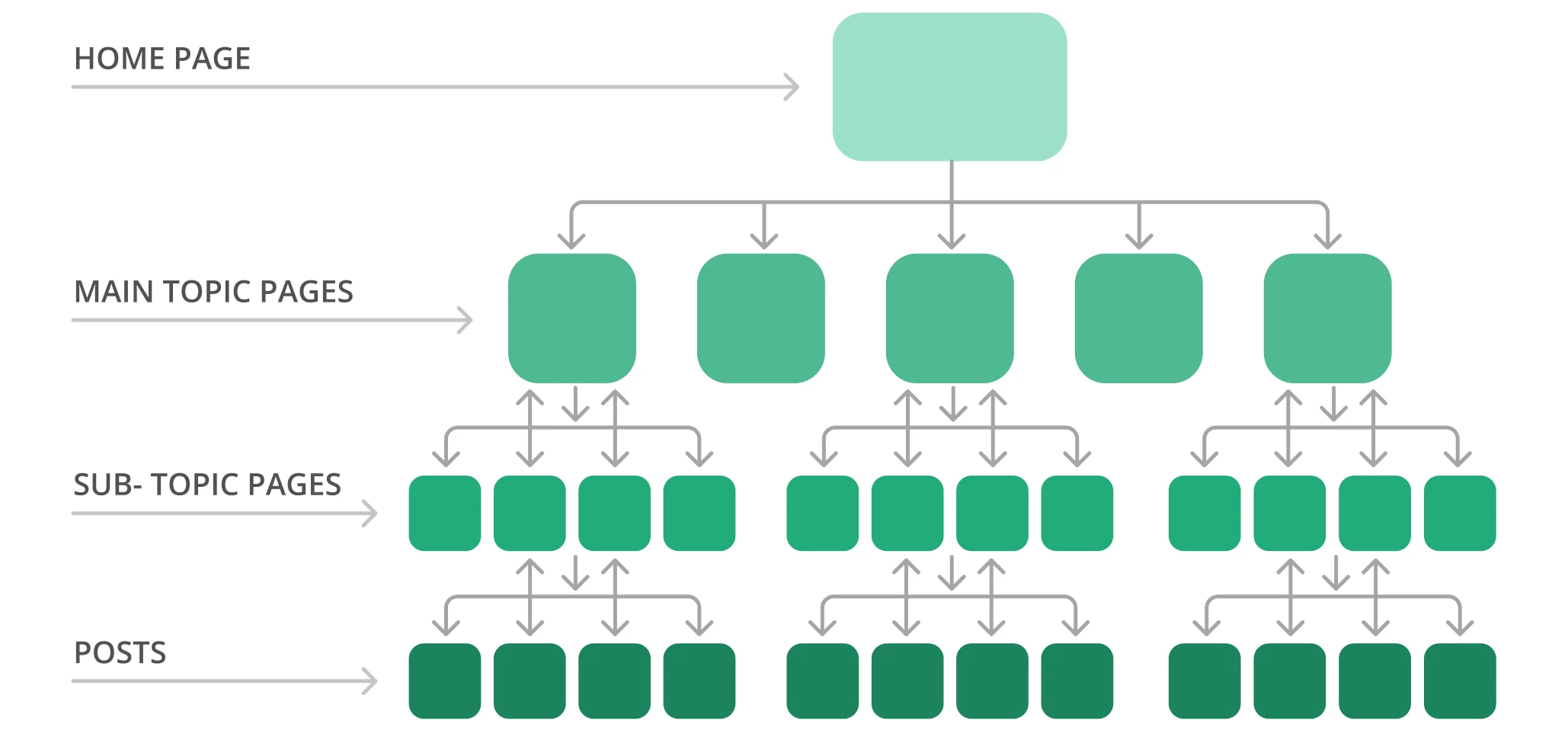

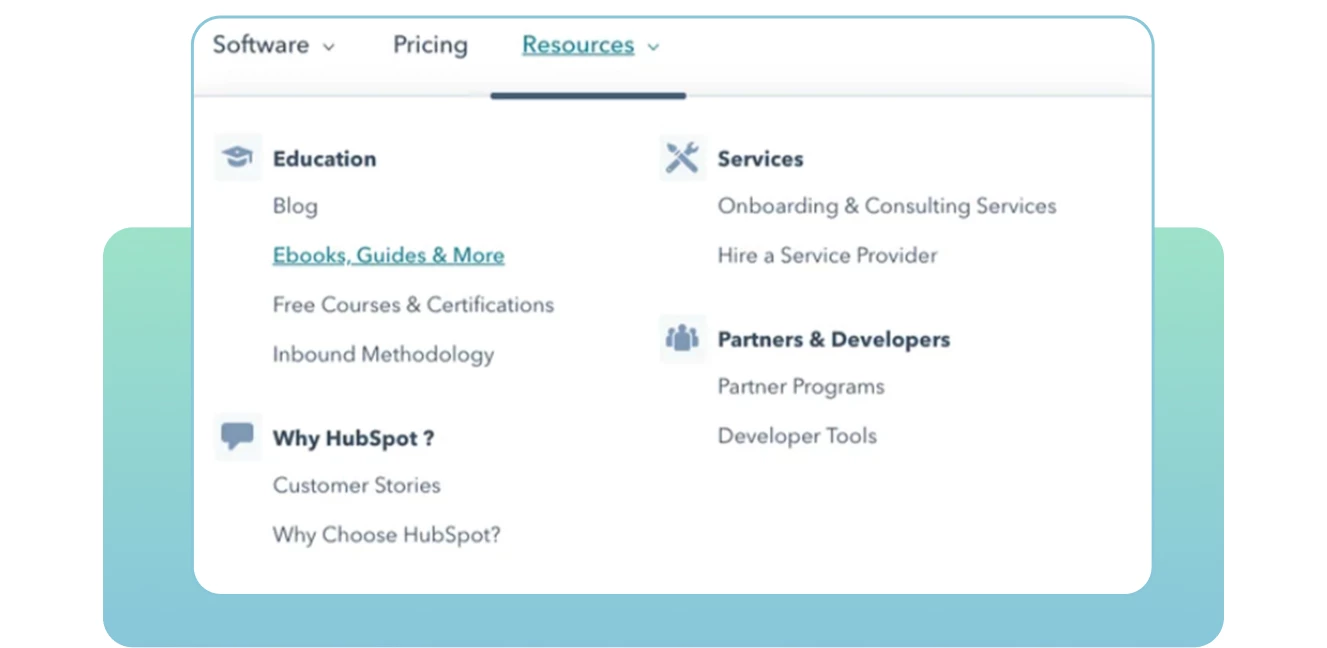

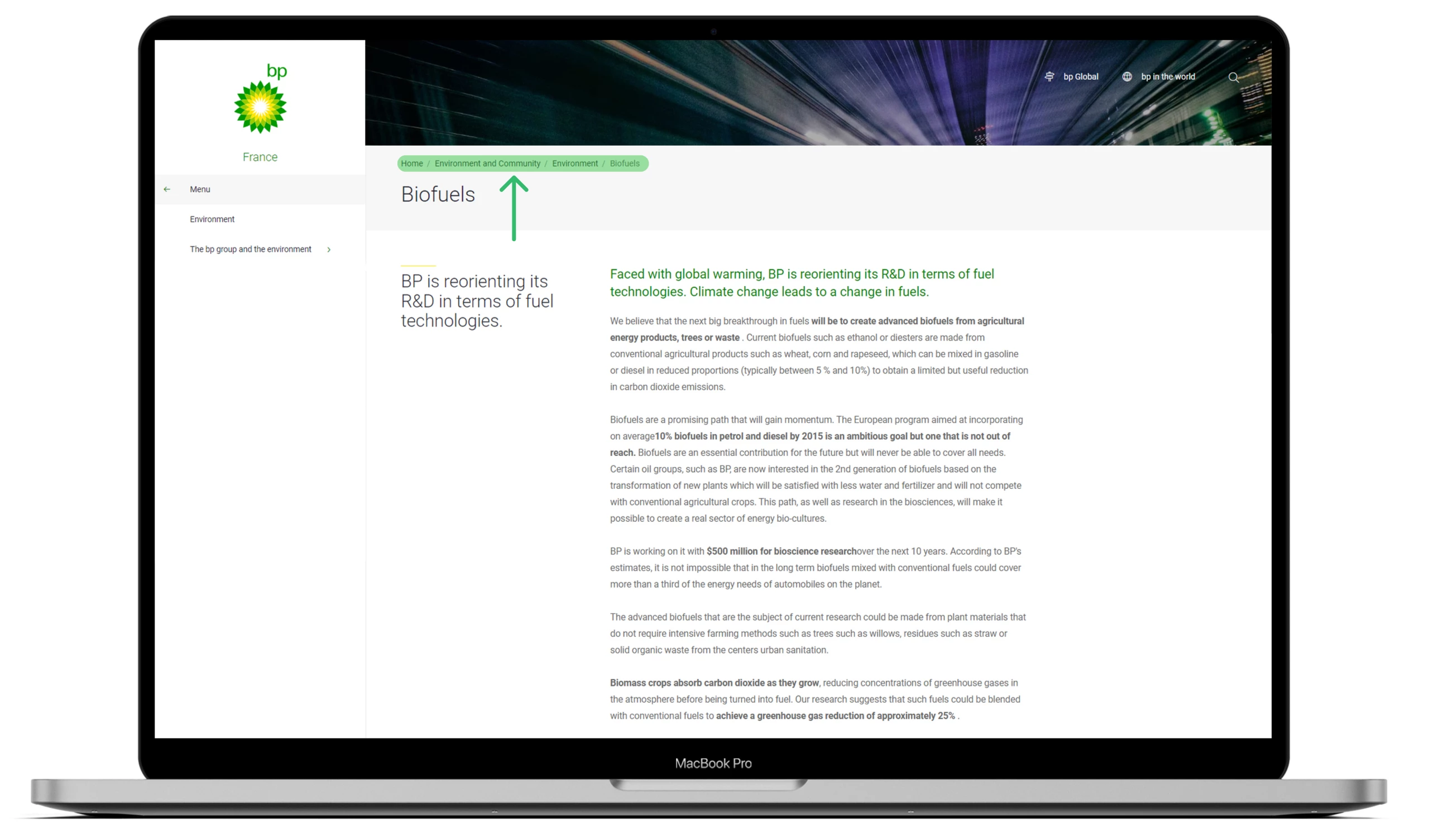

10. Плохая архитектура сайта

Неэффективная структура сайта затрудняет навигацию и индексацию страниц. Страницы, находящиеся глубоко в иерархии или не связанные внутренними ссылками, игнорируются поисковыми системами.

Хорошо организованный сайт улучшает доступность страниц, повышая SEO-показатели и пользовательский опыт.

Пример идеальной структуры — пирамида: главная страница на вершине, разделы и подразделы — ниже.

Решение

- Проведите аудит структуры с помощью Screaming Frog.

- Создайте логическую иерархию с глубиной не более 2-3 кликов от главной страницы.

- Используйте понятные и читаемые URL-структуры с ключевыми словами.

- Избегайте динамических параметров и идентификаторов сессий в URL.

- Реализуйте хлебные крошки для навигации и структуризации сайта.

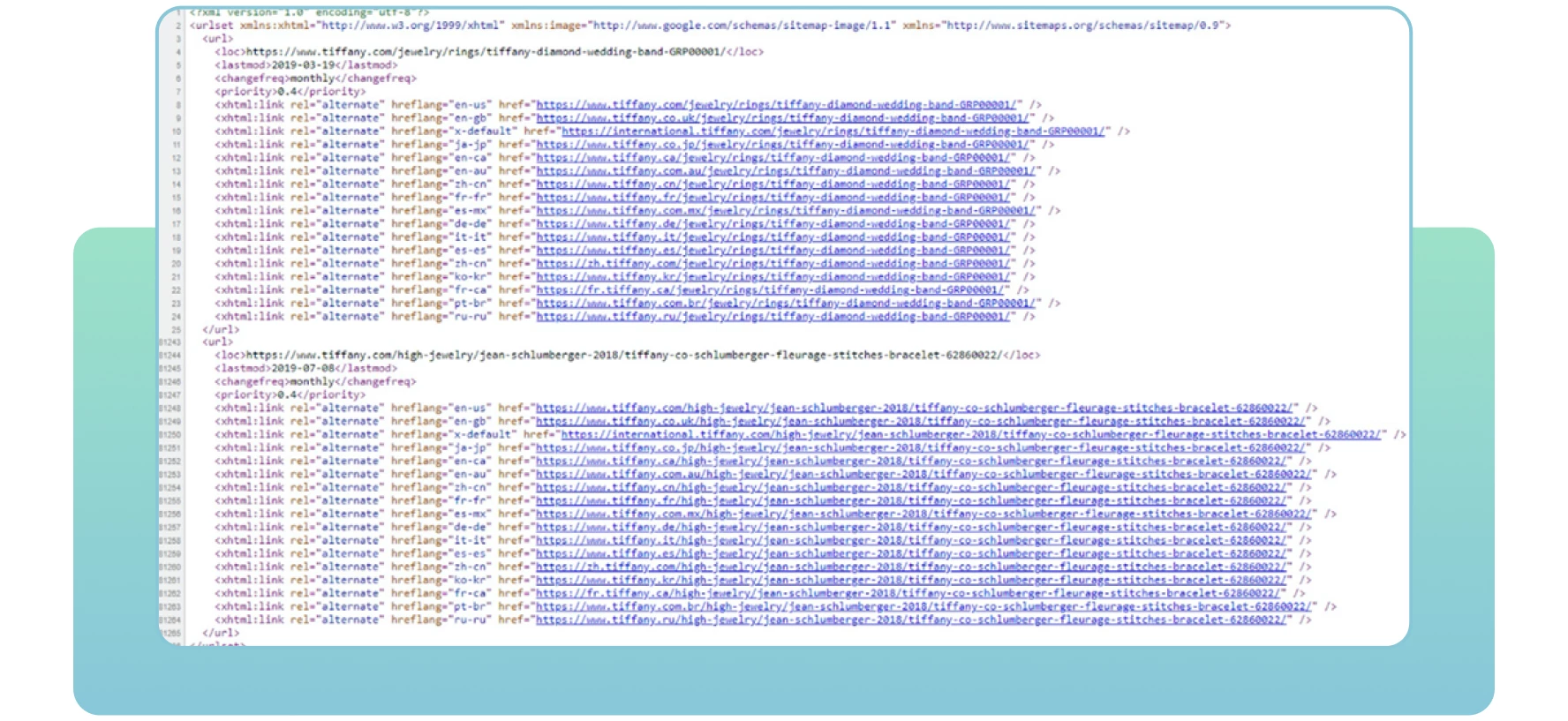

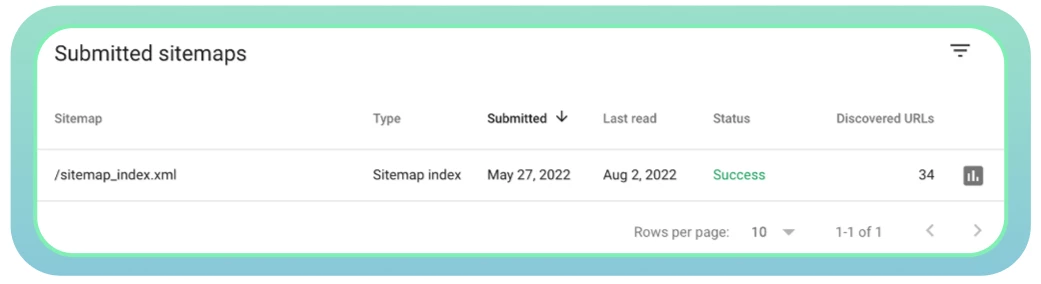

11. Плохое управление файлами Sitemap

Sitemap — это XML-файл, содержащий данные о страницах сайта, которые необходимо проиндексировать. Он помогает поисковым системам понять структуру сайта и быстрее найти нужные страницы.

Неправильно настроенная карта сайта может привести к тому, что важные страницы не будут замечены поисковыми системами.

Решение

- Создайте или обновите sitemap с помощью XML Sitemaps или плагинов.

- Проверьте наличие ошибок сервера, дубликатов и устаревших ссылок.

- Отправьте sitemap в Google Search Console:

domain.com/sitemap.xml - Регулярно обновляйте карту сайта при добавлении или удалении страниц.

- Используйте консоль для отслеживания статуса и устранения проблем.

Заключение

Существует множество причин, по которым страницы сайта могут быть не видны поисковикам. Проблемы с проходимостью напрямую влияют на индексируемость и ранжирование сайта.

Найдите и устраните все ошибки сканирования — это ключевой шаг к тому, чтобы ваш сайт стал видимым и эффективным в поисковой выдаче.

Следуя описанным рекомендациям, вы сможете улучшить техническое состояние сайта и упростить работу поисковых систем и пользователей.

Дорогие друзья! Спасибо за внимание. Надеюсь, статья была полезной. До новых встреч!